Malgré leurs fréquences époustouflantes, les fusillades dans les écoles restent une horreur déconcertante.

Non seulement il y a peu de consensus sur la manière de les arrêter - avec des suggestions allant de restreindre l'accès des armes à feu à l'armement des enseignants - mais il y a encore moins de certitude quant à la raison pour laquelle un élève ouvrirait le feu sur ses camarades de classe.

Maintenant, certains scientifiques commencent à explorer si l'intelligence artificielle (IA) pourrait aider à trouver des réponses. L'idée est que les algorithmes pourraient être en mesure de mieux analyser les données relatives aux fusillades dans les écoles et peut-être même d'identifier des modèles de langage ou de comportement des élèves qui pourraient préfigurer la violence à l'école. La recherche en est encore à ses débuts et la possibilité d'utiliser des machines pour prédire qui pourrait devenir un tireur scolaire soulève des problèmes de protection de la vie privée et d'autres questions éthiques associées à tout type de profilage, en particulier du fait que le processus impliquerait des enfants. L’objectif, cependant, est de voir si le pouvoir analytique des machines intelligentes peut apporter plus de clarté aux tragédies trop souvent absorbées par un tourbillon d’émotions fortes et de rhétorique politique.

Se tourner vers la technologie

L'utilisation de l'intelligence artificielle comme moyen d'apporter une analyse scientifique à quelque chose d'aussi insondable que les fusillades dans les écoles a beaucoup plu à Shreya Nallapati. Elle vient de terminer ses études au lycée dans le Colorado, mais en février, après la mort par balle de 17 étudiants à Parkland, en Floride, Emma Gonzalez, leader étudiante, lui a demandé d'agir.

«Je pensais que nous ne devions pas simplement publier nos pensées et nos condoléances», déclare Nallapati. «Je pensais qu'en tant que génération montante de la génération Y, nous devrions essayer d'utiliser ce que nous savons le mieux, la technologie.»

Donc, Nallapati, qui a étudié l'intelligence artificielle au lycée, a contacté d'autres jeunes femmes qu'elle connaît par le biais d'un programme appelé Aspirations in Computing, géré par le Centre national pour les femmes et les technologies de l'information. Aspirations in Computing encourage les jeunes femmes à entrer dans les domaines de l'informatique et de la technologie.

Nallapati a demandé aux autres membres du groupe de la rejoindre dans un nouveau projet, #NeverAgainTech. Elle espère que cet effort de collaboration aboutira à une compilation et à une analyse d'un large éventail de données relatives aux fusillades dans les écoles, des informations démographiques et socio-économiques sur les anciens tireurs, aux antécédents de consommation de drogue ou de troubles neurologiques, aux disponibilité d'armes à feu dans les États où des attaques ont eu lieu. L’objectif est d’élaborer une analyse plus complète des nombreuses composantes des fusillades dans les écoles que tout ce qui existe actuellement et de rendre le logiciel obtenu accessible au public, notamment aux écoles et aux organismes chargés de l’application de la loi, l’année prochaine.

Évaluation du risque

Une équipe de chercheurs du centre médical de l'hôpital pour enfants de Cincinnati adopte une approche différente en utilisant l'IA pour lutter contre la violence à l'école. Il a publié une étude récente suggérant que l'apprentissage automatique pourrait potentiellement aider les thérapeutes et les conseillers à discerner le niveau de risque que peut présenter un élève.

Les scientifiques ont notamment découvert que l'IA était aussi précise qu'une équipe de psychiatres pour enfants et adolescents lorsqu'il s'agissait d'évaluer le risque de comportement violent, sur la base d'entretiens avec 119 enfants âgés de 12 à 18 ans. Drew Barzman, chercheur principal dans le domaine de l’agression, a déclaré que cela s’appliquait également à l’évaluation du risque de tir en classe.

«Il y a généralement des signes avant-coureurs avant la violence à l'école», dit-il. Selon une étude antérieure dirigée par Barzman, la langue utilisée par un étudiant au cours d'une interview peut aider à distinguer un adolescent à haut risque d'un adolescent à faible risque. Cette étude a conclu que le premier était plus susceptible d'exprimer des sentiments négatifs sur lui-même et sur les actes des autres. Il était également plus susceptible de parler d'actes de violence impliquant lui-même et de jeux vidéo ou de films violents.

L'équipe a franchi une autre étape en utilisant un algorithme d'IA utilisant les résultats de la précédente étude pour analyser les transcriptions des étudiants interrogés pour la nouvelle recherche. Basé sur les schémas linguistiques, il indiquait si une personne présentait un risque faible ou élevé de violence. Plus de 91% du temps, l'algorithme, utilisant uniquement les transciripites, s'alignait sur les évaluations plus approfondies d'une équipe de psychiatres pour enfants et adolescents, qui avaient également accès aux informations fournies par les parents et les écoles.

Les étudiants de l'étude étaient en grande partie recrutés dans des cliniques de psychiatrie externes, des unités de soins hospitaliers et des services d'urgence. Certains avaient récemment présenté des changements de comportement majeurs, mais pour d'autres, les changements étaient plus mineurs. Barzman dit qu'ils ont fréquenté diverses écoles, bien qu'aucune n'ait été scolarisée à la maison.

Selon Barzman, l’étude visait à prédire l’agression physique à l’école, mais on ne sait toujours pas si l’apprentissage automatique pourrait réellement prévenir la violence. L'objectif principal à ce stade est de fournir aux thérapeutes et aux conseillers un outil qui pourrait affiner leurs évaluations des étudiants sur la base d'entretiens. Barzman fait remarquer que l’intention n’est pas de laisser les machines prendre des décisions concernant les étudiants.

"Cela viserait essentiellement à aider le clinicien dans sa prise de décision", déclare Barzman. "Nous leur fournirions une structure de ce que nous considérions être des questions importantes. Il peut être difficile d'interviewer un étudiant, de choisir la bonne information et de tout garder en mémoire. L'idée est de leur fournir un outil qui puisse les aider tout au long du processus et d’accroître la précision de leurs évaluations. "

Matty Squarzoni est un autre partisan du potentiel de l'intelligence artificielle pour lutter contre la violence à l'école. Il est PDG d'une start-up californienne appelée Sitch AI, qui prévoit de commercialiser une technologie qui, selon lui, pourrait aider les écoles à faire face à de telles menaces. L'objectif initial sera de développer un système de capteurs qui permettra aux policiers de détecter l'emplacement précis des coups de feu et de suivre les mouvements d'un tireur dans une école. Mais M. Squarzoni a indiqué que la société cherchait également des moyens d'utiliser l'analyse prédictive pour détecter les problèmes potentiels avant qu'ils ne deviennent violents.

Il pense que l'intelligence artificielle pourrait analyser les données d'un élève et signaler des changements notables dans ses performances ou son comportement. Squarzoni reconnaît les préoccupations potentielles concernant la vie privée, mais affirme que la société ne connaîtrait pas l'identité des étudiants.

«Nous ne parlons pas de créer des profils», dit-il. «Nous considérerions chaque personne comme une entité unique. Mais les humains sont des créatures d'habitude. Quand ils commencent à avoir des irrégularités, c'est à ce moment-là que vous commencez à les regarder. Vous remarquez des drapeaux, et peut-être que les drapeaux commencent à se rapprocher. Ils pourraient être des problèmes de santé mentale, ou peut-être leurs notes sont en baisse.

«Nous ne cherchons pas à pouvoir dire: 'Cette personne va être un tireur.' Nous voulons pouvoir dire: 'Cette personne a besoin d'aide.' "

Pas si vite?

Mais d'autres s'inquiètent sérieusement de l'urgence d'utiliser des algorithmes logiciels pour résoudre des problèmes sociétaux complexes.

«Nous constatons à présent une tendance à l’intelligence artificielle appliquée à des domaines très sensibles à une vitesse alarmante, et les développeurs de ces algorithmes ne comprennent pas nécessairement tous les aspects sociaux, et même politiques, des données qu’ils utilisent», déclare Rashida Richardson., directeur de la recherche sur les politiques à l’AI Now Institute, programme de l’Université de New York qui étudie les implications sociales de l’intelligence artificielle.

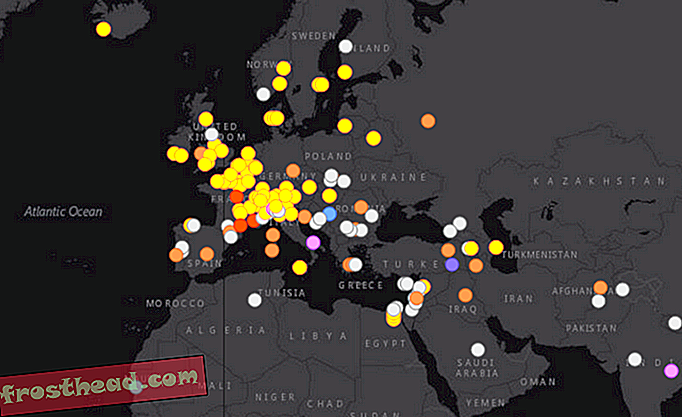

L'un des domaines dans lesquels l'utilisation de l'IA a été critiquée est ce que l'on appelle la police prédictive. Il s’agit de produits logiciels qui analysent les statistiques de la criminalité, puis prédisent où les crimes sont le plus susceptibles d’être commis. Mais les critiques soulignent que des données telles que les arrestations peuvent être le résultat de préjugés humains, qui peuvent finalement être intégrés à l'algorithme.

Il y a toujours un risque d'analyse prédictive et la raison pour laquelle la source des données est un facteur clé pour déterminer à quel point elles peuvent être objectives. Avec l'outil d'IA développé par les chercheurs de l'Hôpital pour enfants de Cincinnati, toutefois, l'analyse est basée sur ce que chaque élève dit au cours d'une interview, plutôt que sur une vaste compilation de statistiques.

Néanmoins, Richardson pense qu'il est important que les équipes qui créent ce type de logiciel soient «interdisciplinaires», afin que les éducateurs, par exemple, participent à des programmes qui évaluent le comportement des élèves.

«Les chercheurs risquent de ne pas comprendre beaucoup les nuances de ce que les gens du monde de l'éducation et de la politique juridique appellent le climat scolaire. Cela inclut la sécurité et les problèmes de comportement », dit-elle. «Le type d’école dans lequel vous vivez dicte souvent la manière dont le comportement et la discipline sont gérés.

"Par exemple, les écoles à charte ont des politiques disciplinaires beaucoup plus strictes", ajoute Richardson. «Les enfants dans cet environnement vont être traités de manière très différente de celle d'une école privée haut de gamme et même dans des environnements différents d'écoles publiques.

«Tenter de comprendre des problèmes très complexes qui suscitent une multitude d’informations et appliquer une solution technique qui en reflète une partie est un problème, car cela peut réitérer les mêmes problèmes que nous rencontrons dans la société ou créer une solution à un problème qui n’existe pas. ”

Selon Richardson, une autre préoccupation est que même si un programme d'IA est développé avec les meilleures intentions du monde, il peut être utilisé d'une manière non anticipée par ses créateurs.

«Une fois que vous avez trouvé ces outils», dit-elle, «ce n’est pas comme si vous continuiez à contrôler leur mise en œuvre ou leur impact sur la société en général».