Tout le monde a entendu parler des nouveaux progrès de l'intelligence artificielle, et en particulier de l'apprentissage par machine. Vous avez également entendu des prédictions utopiques ou apocalyptiques sur la signification de ces avancées. Ils ont été pris pour présager soit l'immortalité soit la fin du monde, et beaucoup de choses ont été écrites sur ces deux possibilités. Mais les IA les plus sophistiqués sont encore loin d’être capables de résoudre facilement les problèmes que les enfants de quatre ans rencontrent. Malgré son nom impressionnant, l'intelligence artificielle consiste principalement en des techniques permettant de détecter des modèles statistiques dans de grands ensembles de données. Il y a beaucoup plus à l'apprentissage humain.

Comment pouvons-nous en savoir autant sur le monde qui nous entoure? Nous apprenons énormément même lorsque nous sommes de jeunes enfants. les enfants de quatre ans connaissent déjà les plantes, les animaux et les machines; les désirs, les croyances et les émotions; même les dinosaures et les vaisseaux spatiaux.

La science a étendu notre connaissance du monde à l'infiniment grand et à l'infiniment petit, au bout de l'univers et au début des temps. Et nous utilisons ces connaissances pour établir de nouvelles classifications et prévisions, imaginer de nouvelles possibilités et créer de nouvelles choses dans le monde. Mais tout ce qui nous parvient du monde est un flot de photons frappant nos rétines et des perturbations de l’air au niveau des tympans. Comment pouvons-nous apprendre tant de choses sur le monde alors que les preuves dont nous disposons sont si limitées? Et comment pouvons-nous faire tout cela avec les quelques kilos de boue grise qui se cache derrière nos yeux?

La meilleure réponse à ce jour est que notre cerveau effectue des calculs sur des données concrètes, particulières et complexes, qui parviennent à nos sens, et que ces calculs donnent des représentations précises du monde. Les représentations semblent être structurées, abstraites et hiérarchisées; ils incluent la perception d'objets en trois dimensions, les grammaires qui sous-tendent le langage et des capacités mentales telles que la «théorie de l'esprit», qui nous permettent de comprendre ce que les autres pensent. Ces représentations nous permettent de faire un large éventail de nouvelles prédictions et d’imaginer de nombreuses nouvelles possibilités de manière créative.

Ce type d'apprentissage n'est pas le seul type d'intelligence, mais il s'agit d'un élément particulièrement important pour les êtres humains. Et c'est le genre d'intelligence qui est une spécialité des jeunes enfants. Bien que les enfants soient extrêmement mauvais en planification et en prise de décision, ils sont les meilleurs apprenants de l'univers. Une grande partie du processus de conversion des données en théories se produit avant l'âge de cinq ans.

Depuis Aristote et Platon, il existe deux moyens fondamentaux de résoudre le problème de savoir comment nous savons ce que nous savons, et ils constituent toujours les principales approches de l'apprentissage automatique. Aristote a abordé le problème de bas en haut: commencez par les sens - le flot de photons et les vibrations de l'air (ou les pixels ou les échantillons sonores d'une image numérique ou d'un enregistrement) - et voyez si vous pouvez en extraire des motifs. Cette approche a été poussée plus loin par des associationnistes classiques tels que les philosophes David Hume et JS Mill et, plus tard, par des psychologues du comportement, comme Pavlov et BF Skinner. De ce point de vue, l’abstrait et la structure hiérarchique des représentations sont une illusion, ou du moins un épiphénomène. Tout le travail peut être fait par association et détection de modèle, surtout s'il y a suffisamment de données.

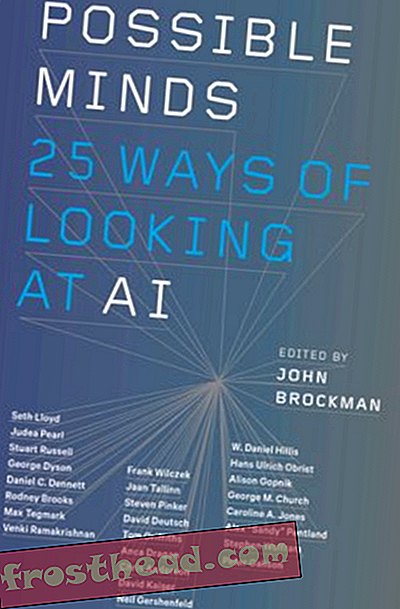

Esprits possibles: 25 façons de regarder l'IA

John Brockman, luminaire du monde scientifique, rassemble vingt-cinq des esprits scientifiques les plus importants, des personnes qui ont pensé au domaine de l'intelligence artificielle pendant la majeure partie de leur carrière, pour un tour de table sans précédent sur l'esprit, la pensée, l'intelligence et ce que cela signifie. sois humain.

AcheterAu fil du temps, il y a eu une balance entre cette approche ascendante du mystère de l'apprentissage et l'approche alternative, descendante de Platon. Peut-être obtenons-nous des connaissances abstraites à partir de données concrètes parce que nous en savons déjà beaucoup, et surtout parce que nous avons déjà une gamme de concepts abstraits de base, grâce à l'évolution. Comme les scientifiques, nous pouvons utiliser ces concepts pour formuler des hypothèses sur le monde. Ensuite, au lieu d'essayer d'extraire des modèles à partir des données brutes, nous pouvons prédire à quoi les données devraient ressembler si ces hypothèses sont correctes. Aux côtés de Platon, des philosophes et des psychologues «rationalistes» tels que Descartes et Noam Chomsky ont adopté cette approche.

Voici un exemple quotidien illustrant la différence entre les deux méthodes: résoudre le fléau du spam. Les données consistent en une longue liste de messages non triés dans votre boîte de réception. La réalité est que certains de ces messages sont authentiques et d'autres sont du spam. Comment pouvez-vous utiliser les données pour les distinguer?

Considérons d'abord la technique ascendante. Vous remarquez que les spams ont généralement des caractéristiques particulières: une longue liste de destinataires, des origines nigérianes, des références à des prix d'un million de dollars ou du Viagra. Le problème est que des messages parfaitement utiles peuvent également avoir ces fonctionnalités. Si vous examinez suffisamment d'exemples de spams et d'e-mails non spam, vous constaterez peut-être que non seulement les spams ont tendance à avoir ces fonctionnalités, mais qu'ils ont tendance à être combinés de manière particulière (le Nigeria plus un million de dollars en cas de problèmes). En fait, il peut exister des corrélations subtiles de niveau supérieur qui différencient les messages de spam des messages utiles - une structure particulière d'orthographes erronées et d'adresses IP, par exemple. Si vous détectez ces modèles, vous pouvez filtrer le spam.

Les techniques d'apprentissage machine ascendantes font justement cela. L'apprenant reçoit des millions d'exemples, chacun comportant un ensemble de fonctionnalités et étiquetés comme spam (ou une autre catégorie) ou non. L'ordinateur peut extraire le motif de caractéristiques qui distingue les deux, même si c'est assez subtil.

Qu'en est-il de l'approche descendante? Je reçois un email du rédacteur en chef du Journal of Clinical Biology . Il fait référence à l'un de mes articles et dit qu'ils aimeraient publier un article de moi. Pas de Nigeria, pas de Viagra, pas de million de dollars; l'e-mail n'a aucune des caractéristiques du spam. Mais en utilisant ce que je sais déjà et en pensant de manière abstraite au processus qui produit le spam, je peux comprendre que cet email est suspect:

1. Je sais que les spammeurs essaient d'extraire de l'argent des gens en faisant appel à la cupidité humaine.

2. Je sais également que les revues légitimes à «accès ouvert» ont commencé à couvrir leurs coûts en facturant les auteurs à la place des abonnés, et que je ne pratique rien de plus que la biologie clinique.

Mettez tout cela ensemble et je peux faire une bonne nouvelle hypothèse sur l'origine de ce courriel. Il est conçu pour inciter les universitaires à payer pour "publier" un article dans un faux journal. L'e-mail résultait du même processus douteux que les autres spams, même s'il ne leur ressemblait absolument pas. Je peux tirer cette conclusion d'un seul exemple, et je peux continuer à tester mon hypothèse plus loin, au-delà de tout ce que contient le courrier électronique lui-même, en recherchant "l'éditeur" dans Google.

En termes informatiques, j'ai commencé avec un «modèle génératif» qui comprend des concepts abstraits tels que la cupidité et la tromperie et décrit le processus de production d'escroqueries par courrier électronique. Cela me permet de reconnaître le spam de courrier électronique nigérian classique, mais aussi d’imaginer de nombreux types de spam possibles. Lorsque je reçois le courrier électronique du journal, je peux travailler en arrière: «Cela semble être le genre de courrier qui proviendrait d'un processus générant du spam.»

La nouvelle passion pour l'IA vient du fait que les chercheurs en intelligence artificielle ont récemment produit des versions puissantes et efficaces de ces deux méthodes d'apprentissage. Mais il n'y a rien de profondément nouveau dans les méthodes elles-mêmes.

Apprendre en profondeur de bas en haut

Dans les années 1980, des informaticiens ont mis au point un moyen ingénieux de faire en sorte que les ordinateurs détectent des modèles de données: l’architecture connexionniste, ou réseau de neurones (la partie «neurale» était et reste métaphorique). L’approche est tombée dans le marasme dans les années 1990 mais a récemment été relancée avec de puissantes méthodes «d’apprentissage en profondeur» comme DeepMind de Google.

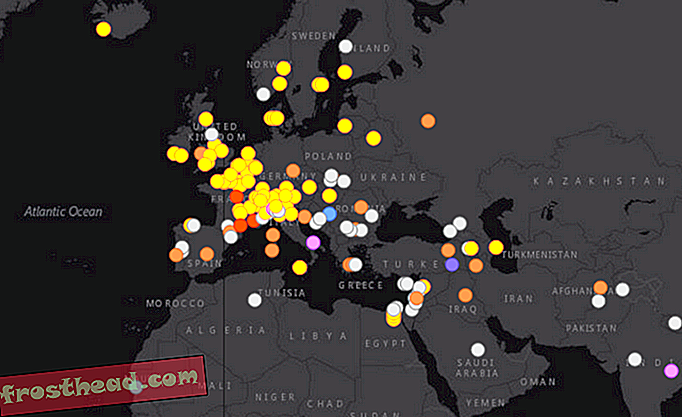

Par exemple, vous pouvez attribuer à un programme d’apprentissage en profondeur une série d’images Internet appelées «chat», d’autres appelées «maison», etc. Le programme peut détecter les motifs différenciant les deux ensembles d'images et utiliser ces informations pour étiqueter correctement les nouvelles images. Certains types d'apprentissage automatique, appelé apprentissage non supervisé, peuvent détecter des modèles dans des données sans étiquettes. ils recherchent simplement des grappes de caractéristiques - ce que les scientifiques appellent une analyse factorielle. Dans les machines à apprentissage en profondeur, ces processus sont répétés à différents niveaux. Certains programmes peuvent même découvrir des caractéristiques pertinentes à partir des données brutes de pixels ou de sons; l'ordinateur peut commencer par détecter les motifs dans l'image brute qui correspondent aux bords et aux lignes, puis rechercher les motifs dans les motifs qui correspondent à des visages, etc.

L’apprentissage par renforcement est une autre technique ascendante qui a une longue histoire. Dans les années 1950, BF Skinner, s'appuyant sur le travail de John Watson, avait programmé des pigeons pour qu'ils réalisent des actions sophistiquées, allant même jusqu'à guider les missiles à lancer aérien vers leurs cibles (un écho inquiétant de l'IA récente) en leur attribuant un programme particulier de récompenses et de punitions. . L'idée essentielle était que les actions récompensées seraient répétées et que les actions punies ne le seraient pas jusqu'à ce que le comportement souhaité soit atteint. Même à l'époque de Skinner, ce processus simple, répété à plusieurs reprises, pouvait conduire à un comportement complexe. Les ordinateurs sont conçus pour effectuer des opérations simples à une échelle qui dépasse l’imagination de l’homme, et les systèmes informatiques peuvent ainsi acquérir des compétences remarquablement complexes.

Par exemple, les chercheurs de Google DeepMind ont combiné l'apprentissage en profondeur et l'apprentissage par renforcement pour apprendre à l'ordinateur à jouer aux jeux vidéo Atari. L'ordinateur ne savait rien du fonctionnement des jeux. Il a commencé par agir au hasard et n'a obtenu des informations que sur l'aspect de l'écran à chaque instant et sur les résultats obtenus. L’apprentissage en profondeur a permis d’interpréter les caractéristiques à l’écran et l’apprentissage par renforcement a récompensé le système pour des scores plus élevés. L'ordinateur a très bien joué à plusieurs jeux, mais il a aussi complètement bombardé d'autres jeux qui étaient tout aussi faciles à maîtriser pour les humains.

Une combinaison similaire d'apprentissage en profondeur et d'apprentissage par renforcement a permis le succès d'AlphaZero de DeepMind, un programme qui a réussi à battre les joueurs humains aux échecs et au Go, doté uniquement d'une connaissance de base des règles du jeu et de certaines capacités de planification. AlphaZero possède une autre fonctionnalité intéressante: il fonctionne en jouant des centaines de millions de jeux contre lui-même. Ce faisant, il supprime les erreurs qui ont conduit à des pertes, et répète et développe des stratégies qui ont conduit à des victoires. Ces systèmes, ainsi que d’autres impliquant des techniques appelées réseaux accusatifs génératifs, génèrent des données ainsi que des données d’observation.

Lorsque vous avez le pouvoir de calcul pour appliquer ces techniques à de très grands ensembles de données ou à des millions de courriers électroniques, d'images Instagram ou d'enregistrements vocaux, vous pouvez résoudre des problèmes qui semblaient très difficiles auparavant. C'est la source d'une grande partie de l'enthousiasme en informatique. Mais il convient de rappeler que ces problèmes - comme reconnaître qu’une image est un chat ou une parole parlée est Siri - sont insignifiants pour un enfant en bas âge. L'une des découvertes les plus intéressantes de l'informatique est que les problèmes faciles pour nous (comme l'identification des chats) sont difficiles pour les ordinateurs - beaucoup plus difficiles que de jouer aux échecs ou de Go. Les ordinateurs ont besoin de millions d'exemples pour classer les objets que nous pouvons classer avec quelques-uns seulement. Ces systèmes ascendants peuvent généraliser à de nouveaux exemples; ils peuvent qualifier une nouvelle image de chat de manière assez précise. Mais ils le font d'une manière tout à fait différente de la façon dont les humains généralisent. Certaines images presque identiques à une image de chat ne seront pas identifiées par nous comme des chats. D'autres qui ressemblent à un flou aléatoire le seront.

Modèles bayésiens de haut en bas

L'approche descendante a joué un grand rôle dans l'IA initiale et a également connu un renouveau dans les années 2000, sous la forme de modèles génératifs probabilistes ou bayésiens.

Les premières tentatives d’utilisation de cette approche se heurtaient à deux types de problèmes. Premièrement, la plupart des types de données probantes peuvent en principe être expliqués par de nombreuses hypothèses différentes: il est possible que le message électronique de mon journal soit authentique, cela ne semble tout simplement pas probable. Deuxièmement, d’où proviennent les concepts utilisés par les modèles génératifs? Platon et Chomsky ont dit que vous étiez nés avec eux. Mais comment pouvons-nous expliquer comment nous apprenons les derniers concepts de la science? Ou comment même les jeunes enfants comprennent les dinosaures et les roquettes?

Les modèles bayésiens combinent des modèles génératifs et des tests d'hypothèses avec la théorie des probabilités. Ils abordent ces deux problèmes. Un modèle bayésien vous permet de calculer à quel point il est probable qu'une hypothèse soit vraie, à la lumière des données. Et en apportant des modifications mineures mais systématiques aux modèles que nous avons déjà et en les comparant aux données, nous pouvons parfois créer de nouveaux concepts et modèles à partir d'anciens. Mais ces avantages sont compensés par d'autres problèmes. Les techniques bayésiennes peuvent vous aider à choisir l’une des deux hypothèses les plus probables, mais il existe presque toujours un nombre énorme d’hypothèses possibles, et aucun système ne peut les prendre toutes en considération de manière efficace. Comment décidez-vous quelles hypothèses valent la peine d'être testées?

Brenden Lake de la NYU et ses collègues ont utilisé ce type de méthodes descendantes pour résoudre un autre problème facile pour les utilisateurs mais extrêmement difficile pour les ordinateurs: la reconnaissance de caractères manuscrits inconnus. Regardez un personnage sur un parchemin japonais. Même si vous ne l'avez jamais vu auparavant, vous pouvez probablement savoir s'il est similaire ou différent d'un personnage sur un autre parchemin japonais. Vous pouvez probablement le dessiner et même concevoir un faux personnage japonais basé sur celui que vous voyez, un personnage qui sera très différent d'un personnage coréen ou russe.

La méthode ascendante de reconnaissance des caractères manuscrits consiste à donner à l’ordinateur des milliers d’exemples de chacun d’entre eux et à lui permettre d’en extraire les principales caractéristiques. Au lieu de cela, Lake et al. a donné au programme un modèle général de la façon dont vous dessinez un personnage: un trait va de droite à gauche; quand vous en avez fini un, vous en commencez un autre etc. Lorsque le programme voyait un personnage en particulier, il pouvait en déduire la séquence des coups les plus susceptibles de l'avoir provoqué - tout comme j'ai déduit que le processus de spam avait conduit à l'envoi de mon courrier électronique douteux. Ensuite, il pourrait juger si un nouveau personnage était susceptible de résulter de cette séquence ou d'un autre, et il pourrait produire lui-même un ensemble de traits similaires. Le programme fonctionnait beaucoup mieux qu'un programme d'apprentissage en profondeur appliqué exactement aux mêmes données et reflétait étroitement les performances de l'être humain.

Ces deux approches de l'apprentissage automatique ont des forces et des faiblesses complémentaires. Dans l’approche ascendante, le programme n’a pas besoin de beaucoup de connaissances pour commencer, mais il a besoin de beaucoup de données et il ne peut être généralisé que de façon limitée. Dans l’approche descendante, le programme peut apprendre de quelques exemples et faire des généralisations beaucoup plus larges et variées, mais vous devez commencer par en approfondir davantage. Un certain nombre d'enquêteurs tentent actuellement de combiner les deux approches, en utilisant l'apprentissage en profondeur pour mettre en œuvre l'inférence bayésienne.

Le succès récent de l'intelligence artificielle est en partie le résultat de l'extension de ces idées anciennes. Mais cela a plus à voir avec le fait que, grâce à Internet, nous avons beaucoup plus de données, et grâce à la loi de Moore, nous avons beaucoup plus de puissance de calcul à appliquer à ces données. De plus, il est un fait incompris que les données dont nous disposons ont déjà été triées et traitées par des êtres humains. Les images de chat publiées sur le Web sont des images canoniques de chat - des images que les humains ont déjà choisies comme "bonnes" images. Google Translate fonctionne parce qu'il tire parti de millions de traductions humaines et les généralise dans un nouveau texte plutôt que de véritablement comprendre les phrases elles-mêmes.

Mais ce qui est vraiment remarquable chez les enfants humains, c’est qu’ils combinent d’une manière ou d’une autre les meilleures caractéristiques de chaque approche et qu’ils vont bien au-delà de ces approches. Au cours des quinze dernières années, les développementalistes ont exploré la façon dont les enfants apprennent la structure à partir de données. Les enfants de quatre ans peuvent apprendre en prenant un ou deux exemples de données, comme le fait un système descendant, et en généralisant des concepts très différents. Mais ils peuvent aussi apprendre de nouveaux concepts et modèles à partir des données elles-mêmes, comme le fait un système ascendant.

Par exemple, dans notre laboratoire, nous fournissons aux jeunes enfants un «détecteur de blicket», une nouvelle machine à découvrir, une machine qu’ils n’ont jamais vue auparavant. C'est une boîte qui s'illumine et joue de la musique lorsque vous mettez certains objets dessus mais pas d'autres. Nous donnons aux enfants un ou deux exemples du fonctionnement de la machine, en leur montrant que, par exemple, deux blocs rouges permettent de la faire disparaître, alors qu'une combinaison vert-jaune ne le permet pas. Même les enfants de dix-huit mois comprennent immédiatement le principe général selon lequel les deux objets doivent être identiques pour réussir, et ils généralisent ce principe à de nouveaux exemples: ils choisiront par exemple deux objets ayant la même forme. le travail de la machine. Dans d'autres expériences, nous avons montré que les enfants peuvent même comprendre que certaines propriétés invisibles cachées font fonctionner la machine, ou que la machine fonctionne selon un principe logique abstrait.

Vous pouvez aussi montrer cela dans l'apprentissage quotidien des enfants. Les jeunes enfants apprennent rapidement les théories intuitives abstraites de la biologie, de la physique et de la psychologie, comme le font les scientifiques adultes, même avec relativement peu de données.

Les remarquables réalisations des derniers systèmes d'IA en matière d'apprentissage automatique, qu'elles soient ascendantes ou descendantes, se déroulent dans un espace étroit et bien défini d'hypothèses et de concepts: un ensemble précis de pièces de jeu et de mouvements, un ensemble d'images prédéterminé. . En revanche, les enfants et les scientifiques modifient parfois leurs concepts de manière radicale, effectuant des changements de paradigme plutôt que de modifier simplement les concepts qu'ils possèdent déjà.

Les enfants de quatre ans peuvent reconnaître immédiatement les chats et comprendre les mots, mais ils peuvent également faire de nouvelles déductions créatives et surprenantes qui vont bien au-delà de leur expérience. Mon propre petit-fils a récemment expliqué, par exemple, que si un adulte souhaite redevenir un enfant, il doit éviter de manger des légumes sains, car ceux-ci font de celui-ci un adulte. Ce type d’hypothèse, une hypothèse plausible qu’aucun adulte ne saurait avoir, est caractéristique des jeunes enfants. En fait, mes collègues et moi avons systématiquement montré que les enfants d’âge préscolaire sont plus aptes à émettre des hypothèses improbables que les enfants plus âgés et les adultes. Nous n'avons presque aucune idée de la façon dont ce type d'apprentissage créatif et d'innovation est possible.

Cependant, regarder ce que font les enfants peut donner aux programmeurs des indications utiles sur les orientations à suivre pour l'apprentissage informatique. Deux caractéristiques de l’apprentissage des enfants sont particulièrement frappantes. Les enfants sont des apprenants actifs. ils n'absorbent pas les données de manière passive, comme le font les IA. Tout comme les scientifiques expérimentent, les enfants sont intrinsèquement motivés à extraire des informations du monde qui les entoure grâce à leur jeu et à leur exploration sans fin. Des études récentes montrent que cette exploration est plus systématique qu'il n'y paraît et qu'elle est bien adaptée pour trouver des preuves convaincantes à l'appui de la formation d'hypothèses et du choix de la théorie. Intégrer la curiosité dans les machines et leur permettre d’interagir activement avec le monde pourrait constituer un moyen d’apprendre un apprentissage plus réaliste et plus étendu.

Deuxièmement, les enfants, contrairement aux IA existants, sont des apprenants sociaux et culturels. Les humains n'apprennent pas de manière isolée, mais exploitent la sagesse accumulée par les générations passées. Des études récentes montrent que même les enfants d’âge préscolaire apprennent par imitation et en écoutant le témoignage des autres. Mais ils n'obéissent pas simplement passivement à leurs professeurs. Au lieu de cela, ils récupèrent les informations des autres de manière remarquablement subtile et sensible, faisant des déductions complexes sur l'origine et la fiabilité des informations et intégrant systématiquement leurs propres expériences avec ce qu'elles entendent.

“L'intelligence artificielle” et “l'apprentissage de la machine” font peur. Et à certains égards, ils sont. Ces systèmes sont utilisés pour contrôler les armes, par exemple, et nous devrions vraiment avoir peur de cela. Pourtant, la stupidité naturelle peut causer bien plus de dégâts que l'intelligence artificielle; nous, les humains, devrons être beaucoup plus intelligents que par le passé pour bien réguler les nouvelles technologies. Mais il n'y a pas beaucoup de fondement pour la vision apocalyptique ou utopique de l'IA remplaçant l'homme. Jusqu'à ce que nous résolvions le paradoxe fondamental de l'apprentissage, les meilleures intelligences artificielles seront incapables de rivaliser avec l'homme de quatre ans.

De la collection à venir POSSIBLE MINDS: 25 Ways to Looking at AI, édité par John Brockman. Publié en accord avec Penguin Press, un membre de Penguin Random House LLC. Droits d'auteur © 2019 John Brockman.