Lorsque vous attrapez quelque chose, votre main fait le plus gros du travail. Votre cerveau dit simplement: "Allez, tu ne t'inquiètes pas de la façon dont cela se passe." Mais avec une prothèse, même la plus avancée, cette action nécessite beaucoup plus d'intentionnalité. En conséquence, de nombreux patients abandonnent leurs membres à la pointe de la technologie.

Contenu connexe

- Comment le piratage de réseaux neuronaux peut-il aider les amputés à craquer des œufs?

- Obtenir la prothèse est facile, comparé à faire ce que vous voulez

Les prothèses modernes reçoivent des commandes sous la forme de signaux électriques des muscles auxquels elles sont attachées. Mais même les meilleures prothèses ne peuvent pas encore faire grand chose. Les utilisateurs ont besoin d'une longue période de formation pour s'habituer au membre. Ils ne peuvent souvent se déplacer que de manière limitée et les utilisateurs doivent basculer manuellement entre les poignées pour accomplir différentes tâches, par exemple pour ouvrir une porte plutôt que de pincer et de tourner une clé. Dans l’ensemble, cela signifie que la main ne peut pas fonctionner de manière transparente avec le cerveau.

Un des outils pouvant aider à résoudre ce problème est la vision par ordinateur. Des chercheurs de l'Université de Newcastle ont monté une webcam sur une main prothétique, l'ont connectée à un réseau de neurones d'apprentissage profond et ont donné les dispositifs à deux personnes amputées dont les bras avaient été amputés au-dessus du poignet mais sous le coude. L'ordinateur a utilisé l'appareil photo pour voir ce que l'utilisateur cherchait et ajuster automatiquement la prise de la prothèse.

Les résultats ont été prometteurs jusqu'à présent. Dans un article paru dans le Journal of Neural Engineering, l'équipe de Newcastle a signalé que les utilisateurs avaient des taux de réussite supérieurs à 80% pour le ramassage et le déplacement d'objets.

«Si nous pouvions améliorer cela à 100%, il serait beaucoup plus fiable d’utiliser la main pour les amputés», déclare Ghazal Ghazaei, étudiant au doctorat à Newcastle et auteur principal du document. utilisé dans la vie réelle, il devrait être sans erreur. "

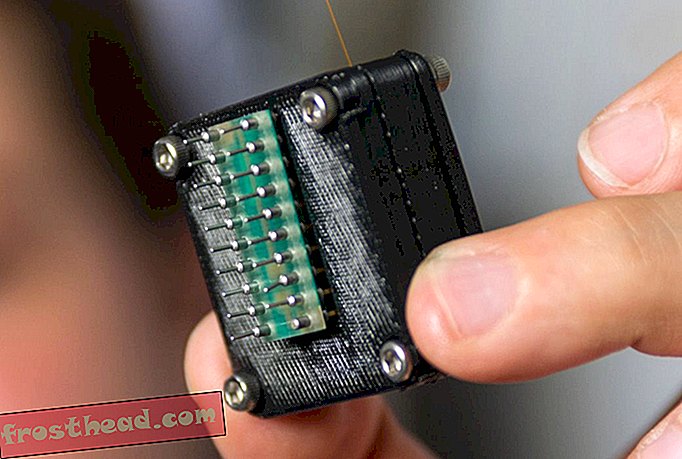

Le dispositif lui-même était une prothèse standard appelée i-limb ultra et la webcam était une Logitech Quickcam Chat peu coûteuse et peu coûteuse. La véritable innovation réside dans la manière dont l'équipe de Ghazaei a mis au point un programme d'apprentissage informatique permettant d'utiliser les informations de la webcam.

Le logiciel reconnaît les motifs dans la forme de l'objet à soulever et les classe en catégories en fonction de la prise dont il a besoin pour les saisir efficacement. Pour enseigner cette technique à l'ordinateur, Ghazaei lui a fourni 72 images, prises par incréments de 5 degrés, de 500 objets. Le logiciel filtre les objets en fonction de leurs caractéristiques et détermine, par essais et erreurs, lesquels appartiennent à quelles catégories.

Ensuite, lorsque la prothèse reçoit un objet, le réseau classe l’image basse résolution en fonction de sa forme large et abstraite. Ce n’est pas nécessairement quelque chose que le système a vu auparavant: la forme générale de l’objet suffit à indiquer à la main quelle prise utiliser. Ghazaei et son équipe ont utilisé quatre types de poignées, à savoir pincement (deux doigts), trépied (trois doigts), paume neutre (comme pour saisir une tasse de café) et paume pronée (la paume tournée vers le bas).

La vision par ordinateur a déjà été utilisée sur des mains robotiques, aussi bien dans les prothèses que dans les robots industriels. Mais ces efforts ont impliqué des objets de taille et de forme standard, comme dans un environnement de fabrication, ou des algorithmes plus lents. Le système mis au point à Newcastle a été en mesure de suivre ce processus assez rapidement pour classer correctement les objets en 450 microsecondes, soit environ 1/2 000 de seconde. «La principale différence réside dans le temps nécessaire pour comprendre et accomplir le travail», déclare Ghazaei. «Pour certains d'entre eux, cela prend environ quatre secondes et d'autres ont besoin de plusieurs instantanés. Pour nous, ce n'est qu'un instantané et c'est très rapide. "

Les impacts de cette technologie vont bien au-delà de la collecte d’articles ménagers. Les systèmes d'imagerie pourraient aider les jambes prothétiques à savoir à quelle distance elles se trouvent du sol et à s'adapter en conséquence, par exemple. Les deux exemples ont en commun un système robotique fonctionnant conjointement avec le cerveau.

«L’idée principale est d’avoir une interaction entre l’appareil robotique et l’humain, ajoutant une certaine intelligence au système robotique», explique Dario Farina, professeur d’ingénierie en neuroréhabilitation à l’Imperial College London, dont le laboratoire étudie les interfaces neuromusculaires pour les corps et les cerveaux. les appareils auxquels ils se connectent.

"Ce n'est pas seulement le patient qui contrôle, avec son cerveau et à travers l'interface neurale, la prothèse, mais c'est aussi le patient qui est aidé par une deuxième entité intelligente, montée sur la prothèse et capable de voir l'environnement", Farnia, qui n’a pas participé à l’étude de Newcastle, déclare: "Le principal défi consiste à partager le contrôle entre l’homme et le système de renseignement."

C'est un début dans la fusion de l'intelligence artificielle avec le cerveau, qui permet de déterminer quelles actions fonctionnent le mieux pour chacun sans créer de conflit. Ghazaei a rencontré ce problème; elle travaille toujours pour gérer la quantité de mouvement large contrôlée par l'ordinateur de la prothèse par rapport aux actions de l'utilisateur. À l'heure actuelle, l'utilisateur pointe la prothèse sur l'objet, l'incite à prendre une photo, puis le bras choisit la prise et l'attrape.

Ce n'est qu'un des nombreux défis à relever. À l'heure actuelle, le système ne peut pas comprendre les objets longs qui s'étendent hors de la vue. Il a des problèmes avec les milieux surchargés. Parfois, il interprète un objet plus éloigné comme un objet plus petit et plus proche. Et Ghazaei dit que l'augmentation du nombre de types de saisie à 10 ou 12 est un autre objectif. Mais déjà, dit-elle, les deux utilisateurs participant à l’essai ont apprécié l’amélioration des performances et la simplicité qu’il confère à l’acte de base de relever quelque chose.